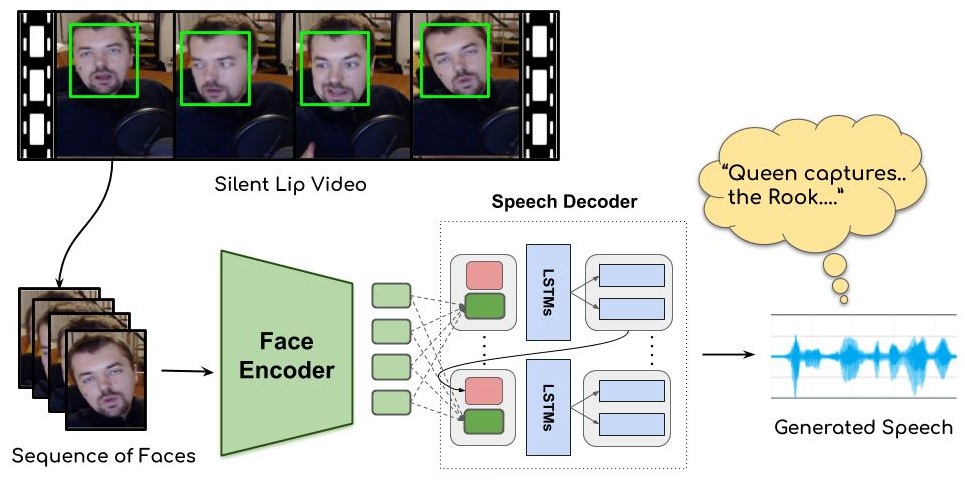

我听说过一些故事,如果您接受了专门的培训,就可以通过嘴唇的移动来知道您在说什么,但是链接中的研究是通过AI实现的。 ,基于注意力的语音解码器会产生梅尔倒谱。之后,将声码器添加到合成中,结果非常有趣。 (链接中有一个演示视频)GitHub具有代码以及公共数据集。

当我看到麻省理工学院的Speech2Face技术时,我感到很惊讶,该技术可以通过语音信号生成人脸,但是Lip2Wav也很有趣。两项研究都具有编码器-解码器结构,并且有望以A2B形式针对各种输入和输出进行各种研究。以下是Lip2Wav的项目页面。

此外,作者还发布了代码和培训数据。我也附上了链接。

COVE-计算机视觉交换

Lip2Wav是一个数据集,用于在不受限制的环境中对特定于说话者的嘴唇到语音进行基准测试。它包含5个演讲者在真实环境中发出自然语音的100多个小时的视频内容。它旨在调查以下问题:“我们如何准确地推断出一个个体……