[융합연구팀 김무성]

최근 스탠포드의 연구자들이 “On the Opportunities and Risks of Foundation Models”라는 논문을 냈습니다 [1]. 여기서 Foundation Model이란 GPT-3와 같은 대규모 데이터로 사전학습된, 전이학습이 일어나는 딥러닝 모델을 말합니다. 자연어처리 분야에서 이 모델들은 여러 이름으로 불리고 있긴 했습니다만 그래도 – 대형 언어모델, 사전학습된 언어모델 등으로 암묵적 합의가 이루어지고 있었죠. 그런데 왜 이들은 따로 이렇게 일견 거창해보이는 이름을 붙인 걸까요?

이 논문에서는 AI 시스템을 구성하는 새 패러다임으로까지 최근의 사전학습형 거대 언어모델(Large-Scale Pretrained Model)들을 바라볼 수 있다고 주장하고 있습니다. BERT, GPT-3, CLIP 등이 현재의 자연어처리 연구들과 산업적 응용을 특정 방향으로 밀어붙이고 있는 것은 사실입니다. 데이터는 광대해지고, 모델은 거대해지고 있습니다. 그렇지만 이것이 그렇게 ‘패러다임 변화’라고 부를 수 있는 정도일까요? 아직까지도 ‘딥러닝’은 통계의 연장이니 ‘마케팅 거품일 뿐이다. 새로운 것은 없다’라고 주장하는 연구자들도 있습니다. 그러니 기술적으로 딥러닝 기존 연구들을 잘 활용하는 것에 불과해보이는(본심은 그저 돈으로 데이터와 컴퓨팅 연산을 쏟아부은 것 뿐이잖아 라고 말하고 싶은) GPT-3에 대해 ‘이것이 새 패러다임이다’라는 주장은 너무 성급해 보인다고 지적하는 사람도 꽤 됩니다.

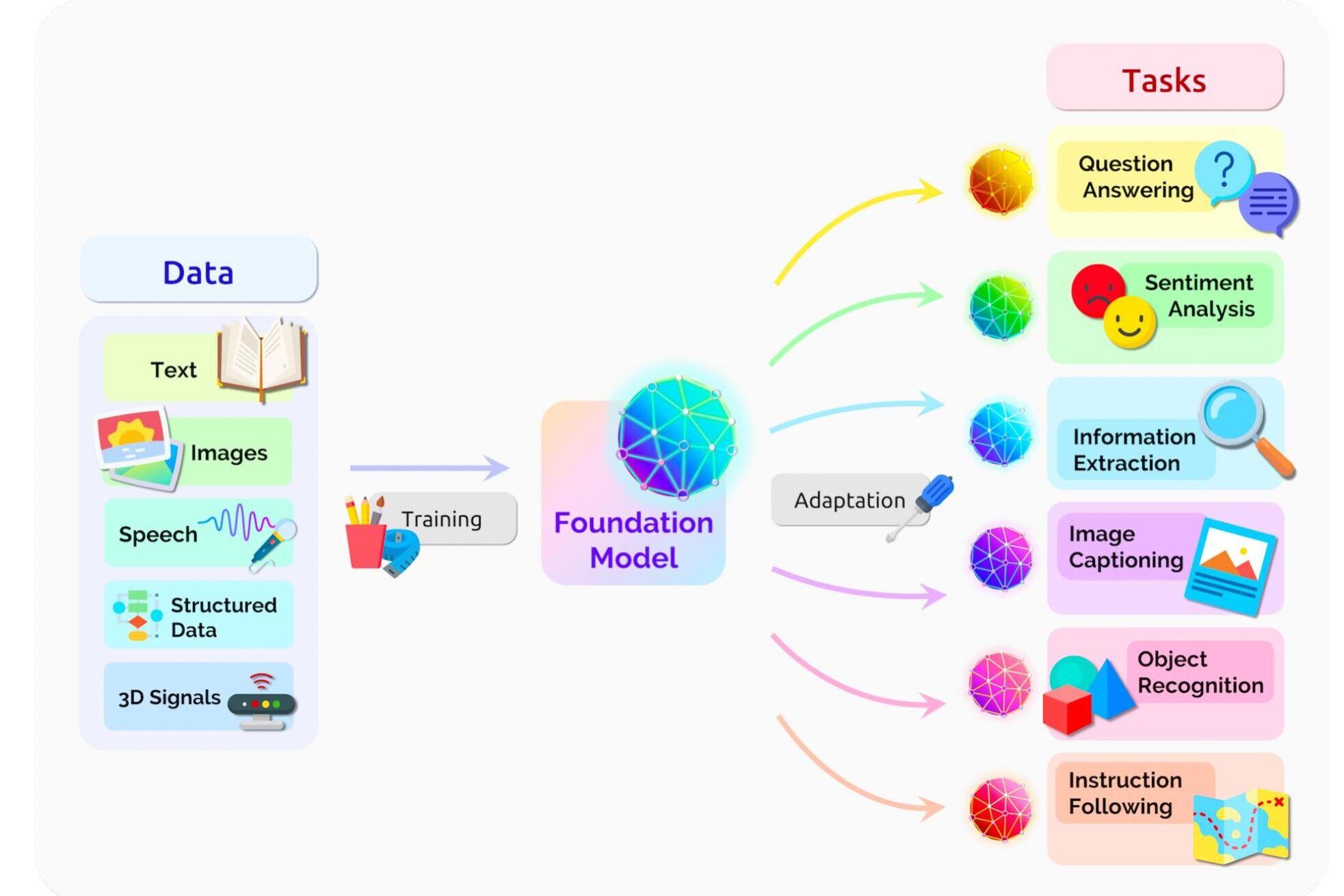

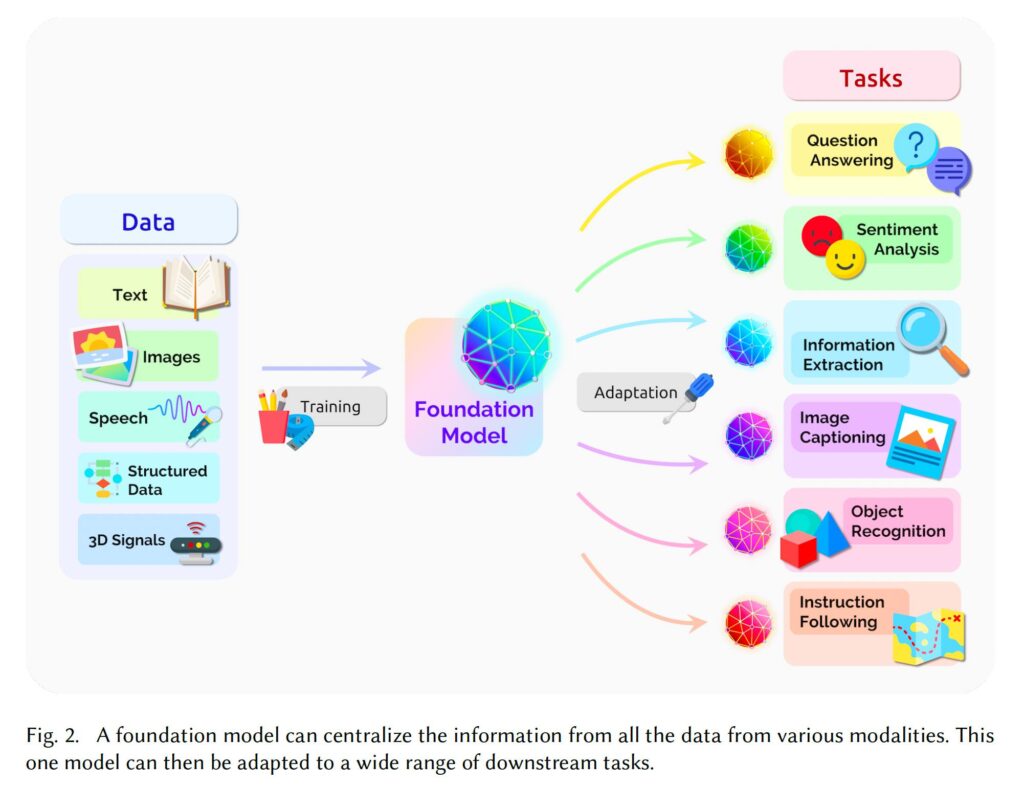

논문에서 연구자들은 위의 그림처럼 Foundation Model의 특성을 도식화합니다. 여러 도메인/모달의 데이터를 한번에 학습시켜서 Foundation Model을 만들고, 이 하나의 모델로 각종 문제를 풀어나갈 수 있다는 것이죠. 최근의 자연어처리에서 주류가 되고 있는 ‘큰 모델 사전 학습하여 범용 능력 가지게 한’ 후 ‘각종 과제로 쉽게 적용할 수 있게’하는 형식의 전이학습 전략을 그대로 따릅니다. 각종 과제로 어떻게 전이 학습을 하느냐 부분에서 최근의 연구 성과들이 조금씩 전진을 보이고 있죠. 파인튜닝, 경량형 타겟 모델 결합, 프롬프트 튜닝, 어뎁터 튜닝, 인컨텍스트 프롬프팅 등등 여러 방식등이 제안되고 있습니다. 데이터 왕창 넣고 미리 훈련시킨 후 여러 문제에 적응시키는 전략으로 사람만큼 여러 자연어처리 과제를 잘 푼다는 BERT가 나온지 얼마 안지난듯 한데, 그냥 데이터 더더더 모아서 학습시켰다는 GPT-3가 연이어 나오고, 이 GPT-3가 ‘새 과제를 위해 소수의 샘플만 있어도 금방 학습이 된다는’ 퓨샷 러닝의 가능성을 보이면서 더 이 방향들의 연구가 급물살을 타고 있는 느낌입니다.

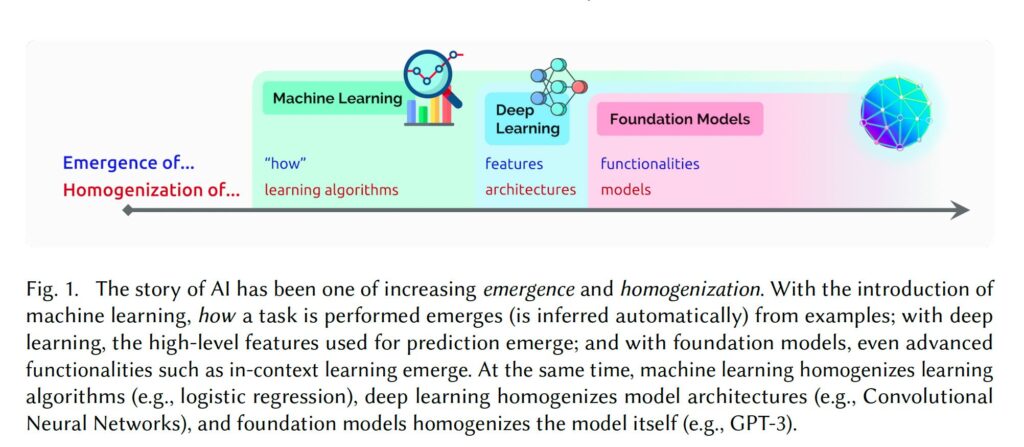

근데 그러면 그냥 BERT 혹은 GPT-3라고 하면 되지 않느냐? 이 논문에서 나온 여러 특성들은 사실 대부분 GPT-3의 특성입니다. 그래서 한 연구자 겸 유튜버는 ‘왜, 제목에 거창한 이름을 붙이니, 왜 GPT-3를 GPT-3라고 말하지 못하니’라고 비판하기도 했죠 [2]. 그런데 논문에서는 어떤 측면에 주목해서 ‘패러다임 전환’이라는 표현까지 쓰고 있는 것일까요? AI 시스템을 구축하려는 지금까지의 시도들을 크게 몇 단계로 나눠서 보여주고 있는 아래 그림을 보시죠. 논문에서는 이 단계를 나누는 주요 요소 두 가지를 소개합니다. 하나는 Emergence, 하나는 Homogenization 입니다.

Emergence는 구글 번역을 하면 ‘출현’으로 나오네요. 혹은 인지과학적 전통에서는 ‘창발’이라고도 하구요. AI 시스템을 구축하려는 입장에서 이 축은, 연구자가 직접 설계하고 제어하는 측면이 아닌데 나타난, 혹은 나타나게 유도한 어떤 특성을 말합니다. 그림에서 축의 왼쪽에 있는 머신러닝 기반 시스템은 데이터를 통해 문제를 어떻게 풀어야 하는지(how)를 학습합니다. 규칙 기반 방법론과 달리 입력과 출력의 매핑하는 방법을 유도하여 나타나게 하는 것이죠. 그림 중간에 나오는 딥러닝 모델로 개발하게 되면 ‘이 문제를 풀 때 어떤 특징(feature)이 좋은지’도 학습으로 해결할 수 있게 됩니다. 그림 맨 오른쪽에 있는 Foundation Model에서는 ‘기능’이 emergence 하게 됩니다. ‘번역’이라는 기능, ‘특정 대화’라는 기능, ‘물체를 탐지’하는 기능 등을 데이터를 통해 유도할수 있게 되는 것이죠. 약간 ‘기능’으로 오면 모호하게 느껴지는 지점이 있지만 일단 비즈니스 단위에 매핑될 수 있는 특정 문제 풀이 기능 정도로 이해하면 될 것 같습니다.

그러면 이젠 Homogenization 이라는 측면에서 보겠습니다. 구글 번역으로는 ‘균질화’라고 하고, 보통 학계에서는 ‘동질화(?)’라고 많이들 부르는 것 같아요. 대략 이 논문에서는, AI 시스템을 구축할 때 풀어야 할 문제의 형태에 독립적인 풀이 방법이라는 의미에서 쓰고 있습니다. 그림에서 왼쪽에 있는 머신러닝 부분을 볼까요? 어떤 문제를 풀든 머신러닝을 적용할 때 학습 알고리즘 자체는 같은 것을 적용할 수 있다고 말합니다. 예를들어, 풀어야 할 문제가 이미지에서의 물체 인식이든, 자연어처리에서의 긍정/부정 판단이든, 추천 시스템에서 사용자가 제시된 아이템을 선택할지 말지에 대한 여부이든, ‘분류’문제로 정의하고 로지스틱 리그레션 학습 알고리즘을 동일하게 적용할 수 있습니다. 다만 특징을 어떻게 정하느냐랑 이 문제를 풀기에 더 강력한 분류 알고리즘은 없는지 등은 사람이 정해줘야 하지만요. 이런 식으로 바라보면 딥러닝 때는 신경망 모델들을 어떤 식으로 연결할지 그 구성을 거의 동일하게 적용할 수 있고(시간적/공간적 순서가 중요한지, 특징 추출을 아웃풋을 아는 상황에서 자동 인코딩할지, 공간적 근접성이 중요한지 등), 이제 Foundation Model의 단계로 가면, 문제에 맞춘 특정한 구성도 취할 필요가 없어진다는 것이죠.

이들의 주장을 개발 단계에서의 편의성이라는 측면에서 보면 꽤 큰 변화가 다가오고 있는 것이 맞습니다. 하늘에서 내려다보는 눈을 취하면 다 고만고만하게 보입니다. 딥러닝은 신경망의 뉴브랜드가 맞고, 단순히 GPU 등의 계산파워와 대량 데이터 입수 가능성이 커지면서 비선형 매핑을 잘 취하게된 특정 통계 모델로 바라보는 것도 맞습니다. 그리고 겨우 ‘특징 추출/선택’ 등을 자동화해준 것일 뿐 ‘일반화된 지능’으로는 반발톱만큼도 전진하지 못했다고 말할 수도 있겠죠.

어찌보면 타당합니다. 하지만 산업이라는 측면에서는 그 작은(?) 편의성이 불러온 변화를 한번 생각해 봅시다. 딥러닝이 마케팅 용어라고 비난받고 근 5년 이상이 흘렀습니다. 초기에 기존 머신러닝에서 어떤 알고리즘을 쓰고 어떤 특징을 만들어야 할지 사람이 관여하면서 늘 고숙련 연구자들이 필요했고, 이들이 학계와 산업계를 잇는 일종의 바틀넥이 되고 있었는데, 특징 추출을 자동화하는 길이 열리면서 모델 아키텍쳐에 좀 더 집중하는 양상으로 흘렀습니다. 그리고 자동 특징 추출이 완벽하지 않기 때문에, 혹은 이를 위해 데이터가 많이 필요로하기 때문에 점점 이 생태계는 데이터를 수집하고 처리하는 쪽으로 더 집중하게 되었죠. 그리고 모델 아키텍쳐 연구 결과물은 기존 머신러닝보다는 재현이 쉽고 실무가들이 쉽게 따라하고 확장할 수 있게 되면서 점점 머신러닝은 장인이 관여하는 연구에서 공장식 자동화가 도입되는 산업의 형태로 가속화되고 있습니다.

이걸 AI라고 하든, 머신러닝이라고 하든 용어야 어찌되었든 – 특정 문제를 학습 기반으로 풀기 위해 데이터를 더 소중히 생각하고, 연산 역량을 키우고, 모델의 예측 결과에 대한 피드백을 시스템에 자동으로 피드백하려는 시도를 하는 직군/조직들이 증가하여 왔죠. 그리고 최근의 빅모델은 다시 이 지점의 실천의 양상을 바꾸고 있습니다. 도메인과 과제마다 어느 이상의 데이터를 수집하고, 이 이종의 데이터와 모델, 그 예측에 대한 사용자의 피드백 따로 관리하기 위해 드는 무수한 노력이의 초점이 바뀔 수 있게 되는 것이죠.

Foundation Model 같은 모델을 중심으로 하는 연구/개발 전략이 만약 더 대세가 된다면 – 풀어야 할 문제가 많이 발생하는 원인이 되는 ‘개발/관리 복잡성 – 이질적 요소의 정도’는 사전학습을 위한 데이터 수집과 가공 단계에서 최대한 처리하게 될 수 있을 것이고, 이는 AI 시스템 개발이 데이터 관리와 처리에 더 힘을 집중하게 된다는 것을 의미합니다. 대신 이것은 필요로 하는 자본 규모가 더 커지게 되고 빅테크 기업 위주로 Foundation Model 을 연구/개발/배포하고 될 수 밖에 없는 것이죠. 물론 적정한 가격으로 이 모델들에 접근하게 할 수 있다면 응용하는 입장의 소규모 연구/기업들도 나쁘진 않겠지만요 – 그래도 중앙집중도가 높아지고 어떤 측면에서는 연구/개발 종속성이 심화된다고도 할 수 있겠습니다. 그 외에도 여러가지 고려해야할 사항이 생긴다고 논문에서 매우 상세하게 설명하고 심지어 이에 대해 워크샵도 열었어요 [3]. 더 상세한 내용을 알고 싶으신 분들은 논문 일독과 영상 시청을 추천합니다.

하나의 지능으로 모든 문제를 해결한다. 이것이 딥마인드의 모토죠. 또는 AGI(인공 일반 지능)을 추구하는 연구자들이 좋아하는 슬로건입니다. 이 논문에서는 AGI라는 말을 전면에 내세우진 않습니다. 그냥 Multimodal Multipurpose 모델이라고 좀 더 실용적으로 부르죠. 하나의 모델로 이미지도 다룰 수 있고, 음악도 다룰 수 있고, 액션도 생성하고, 텍스트도 처리합니다. 그리고 번역에도 쓰고 법률문서 분석에도 쓰고 대화 시스템도 만들고 동영상 검색에도 적용할 수 있는 모델이라는 것입니다. 하나의 모델로 말이죠. 그리고 동일한 개발 절차를 통해서요. 사실 이 정도면 대중이 떠올리는 AGI까지는 아니지만 그 방향으로 가는 길에 계속 서 있다고 볼 수 있지 않을까요? 이 논문에 참여한 연구자들이 AGI 열풍에 대해 어느정도 거리를 두고 큰 일꾼 큰 모델 전략을 비판적으로 검토하던 전문가들이었다는 것을 생각해 보면 꽤 급진적 전향인 지점이 있습니다.

저는 이번 논문에서 제시한 Foundation Model이라는 용어와 도식들을 보면서, 과거 연금술에서 목표로 하던 ‘현자의 돌’을 떠올렸습니다. 과연 돌에서 금을 만들려던 그 시도처럼, 그저 사람들이 남긴 행동의 편린일 뿐인 데이터를 ‘지능’으로 변환하는 현자의 돌을 만들어낼 수 있을까요?

연금술사들이 만들려던 현자의 돌은 일종의 원소 변환기라고 볼 수 있습니다. 지금은 원칙적으로 특정 원소의 구조를 바꿔서 금으로 다이아몬드로 바꿀 수 있다고 합니다. 다만 효율이 안나는거죠. 어쩌면 실제 연금술사들의 목표였던 현자의 돌이 원칙적으론 가능은 하나 현실적으로 매우 비효율적이기 때문에 근본적으로 폐기될 수 밖에 없다는 그 운명처럼, 지금의 거대 모델의 시도들은 매우 비효율적인 방식임이 드러날지도 모릅니다. 얀 르쿤의 말처럼 아직 딥러닝은 섀넌의 정보이론을 기다려야 했던 통신산업 실천가들, 열화학을 기다려야 했던 증기기관 엔지니어들과 같은 상황이고, 현재 딥모델을 빅모델화하는 Foundation Model의 방향은 우리를 잘못된 곳으로 이끌고 있는 것일지도 모릅니다.

하지만 저는, 결국 쓸모없다/불가능하다는게 밝혀진 현자의 돌을 추종하던 사람들과 그 후예들을 통해 어떤 새 학문이 탄생하고 세상이 그 영향을 받았는지 떠올려봅니다. 그리고 이 시대의 연금술사들이 쫓고 있는 것에 대해서 상상합니다. 딥마인드가 계속 길고 화려하며 쓸모없는 로켓을 쏘며 현혹하고, OpenAI는 규모를 통해 우리를 유혹하는 그 목표 말이죠.

참고

[1] On the Opportunities and Risks of Foundation Models – https://arxiv.org/abs/2108.07258

[2] [ML News] Stanford HAI coins Foundation Models & High-profile case of plagiarism uncovered – https://www.youtube.com/watch?v=tunf2OunOKg&t=1191s

[3] Workshop on Foundation Models – https://www.youtube.com/watch?v=RLrjKGN89Fc&list=PLYLBSCrrqNXz1RQCVwv7mApexCcn7Bybk