Few shot learning만으로 모든 자연어 task에 적용할 수 있는 가능성을 보여준 초대규모 언어 모델의 대명사 GPT-3의 학습 비용은 한화로 약 40억원으로 추산된다고 합니다. GPT-2의 경우는 약 4천만원. 아무리 재활용성이 높다고 해도 웬만한 회사에서는 R&D로 투자하기 힘든 금액입니다. (누군가 KoGPT-3를 만들어서 배포해주기를 바랄 뿐^^)

언어 모델의 스케일에는 미치지 못하지만, 이미지 모델 또한 유사한 시도로 구글의 Big Transfer가 있습니다. 일반적으로 transfer learning 목적으로 활용되는 모델들은 ImageNet의 일부(약 백만장)를 사용하여 학습되었는데, ImageNet-21k (천사백만장), JFT (3억장)으로 학습시켜서 다양한 task들을 이 transfer learning만으로 대응하겠다는 것입니다. JFT로 학습된 모델은 오픈되지 않았지만, ImageNet-21k으로 학습된 ResNet 모델들은 오픈되어 누구나 사용할 수 있습니다. (개인적으로 왜 Google Inception이 아니라 Microsoft ResNet을 썼을까? 하는 의문이 있습니다)

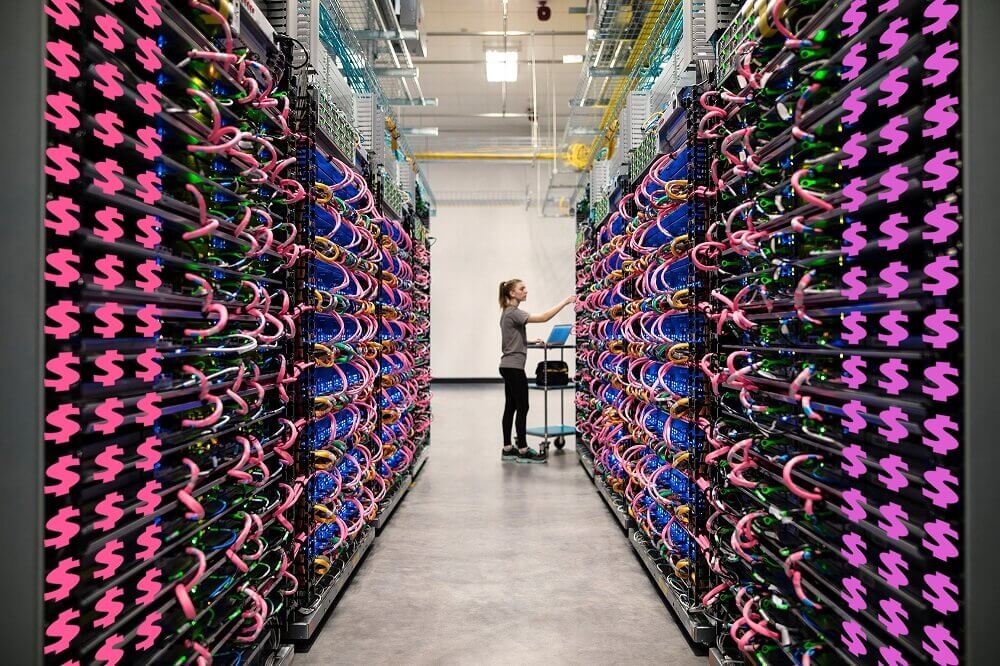

각 task에 최적화된 데이터들을 이용하여 각각 모델을 학습시키는 것이 아니라 초대규모 데이터로 학습된 단일 모델 기반으로 transfer learning을 시도하는 방법은 앞으로 선택이 아니라 필수가 될 가능성이 있다고 봅니다. 사실 이게 나쁘기만 한 것은 아닌 것이, 대규모 학습 인프라를 갖추지 못한 회사들이라고 해도 GPT-3 + few shot learning, 혹은 Big Transfer + fine tuning으로 최고 수준의 모델을 만들 수 있는 길이 열렸기 때문입니다. (물론 Big Transfer는 아직 훨씬 더 bigger해져야…)

링크는 제목이 아주 마음에 드는, 위와 관련된 글입니다.

Everyone can use deep learning now