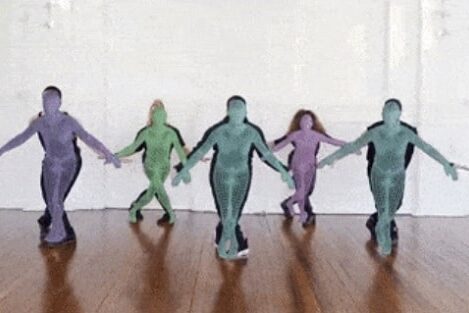

Human-Like AI의 시각화 부분을 구현하기 위해서는 3D 휴먼 모델을 어떻게 만들고, 움직일 것인가에 대한 고민이 필요한데 기존 다양한 접근 방법이 있지만, 그 중 하나로 Max Planck ETH Center에서 CVPR 2020에 발표한 VIBE(Video Inference for Body Pose and Shape Estimation)를 들 수 있습니다.

3D로 휴먼 모델을 표현하는 방법은 다양하지만, SMPL(Skinned Multi-Person Linear) 모델은 수천번 이상의 바디 스캔 데이터로부터 만들어진 버텍스 기반의 파라미터 모델입니다. VIBE는 기본적으로 영상으로부터 body pose와 shape를 추정하여 SMPL 모델의 파라미터들을 생성해 내는 알고리즘이라고 볼 수 있습니다.

VIBE의 구현은 오픈 소스로 공개되어 있으며, 데모 코드와 학습 코드가 PyTorch로 구현되어 있습니다. 주요 특징 중 하나로, 다수의 사람이 등장하는 임의의 영상에 대해서 동작하도록 만들어져서 활용성이 상당히 높습니다. 또한 대부분의 유사 알고리즘들이 실시간 구현이 어려운데 비해, 이 알고리즘은 RTX 2080Ti에서 30 FPS로 처리가 가능하다고 합니다. 데모 코드는 FBX 등 대다수의 3D 그래픽 소프트웨어에서 지원하는 포맷의 파일을 바로 생성할 수 있기 때문에 쉽게 적용할 수 있다는 점도 장점이라고 볼 수 있습니다.

다음은 공개된 데모 영상 및 github 링크입니다:

mkocabas/VIBE

Official implementation of CVPR2020 paper “VIBE: Video Inference for Human Body Pose and Shape Estimation” – mkocabas/VIBE