[선행연구팀 김무성]

이터널 선샤인(Eternal sunshine)

미셀 공드리 감독의 영화 ‘이터널 선샤인’은, 짐 캐리와 케이트 윈슬렛이 커플로 나오는 기억과 이별에 대한 로맨스 SF(?) 영화입니다. 영화에서는 기억을 지울 수 있는 기술이 나옵니다. 남자 주인공 짐 캐리는 여자친구와 싸웠고 곧 후회하고 화해를 하러 그녀를 찾아가죠. 그런데 여자친구 케이트 윈슬렛이 자신과 연애하던 기억을 지웠다는 것을 알게됩니다. 홧김에 짐 캐리도 그녀에 대한 기억을 지우는 시술을 요청하죠. 그리고…

우리는 인공 해마를 만들고 있습니다

왠 영화 이야기? 라고 하신다면, 오늘 소개해드릴 내용이 딥마인드가 최근에 낸 ‘에이전트 기억 시스템’ 관련 논문 중 하나이기 때문입니다. 유일하진 않지만 거의 독보적으로 ‘기억’이라는 것을 인공지능에게 부여하고 싶어하는 연구 집단이 딥마인드라는 것은 모두가 인정하는 사실이죠. 심지어 알파고 때 내한했던 딥마인드의 수장 ‘데미스 하사비스(Demis Hassabis)’는 공공연하게 인간의 뇌에서 ‘기억’과 매우 밀접하다고 여겨진 ‘해마’를 인공적으로 모방하려는 연구를 하고 있다고 말했습니다.

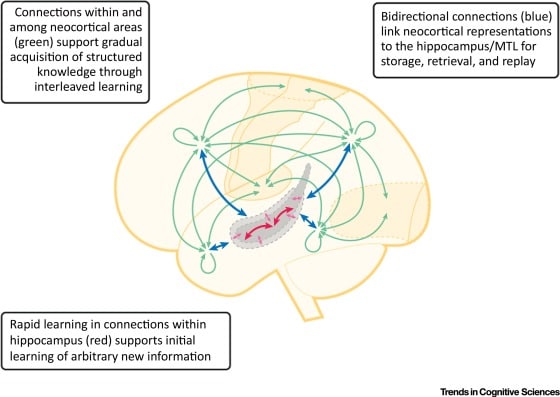

그 뒤로 딥마인드는 포유류의 해마에서 영감을 얻은 ‘인공지능 기억 시스템’을 꾸준히 제안하고 있습니다. 해마의 빠른 패턴 기억 부분과 대뇌피질의 느린 일반화 기억 부분이 동시에 작용한다는 점을 고려한 상보적 기억 시스템, 경험 재생 버퍼 시스템, 신경망에서 기억을 저장하는 부분과 그걸 다루는 메커니즘을 분리하는 시스템(외부 기억 신경망), 일화적 기억 시스템, 예측을 인코딩하는 기억 시스템, 기억될 내용의 모달을 분리하여 구성하는 듀얼 인코딩 기억 시스템, 기억이 저장-인출이 아니라 경험 인스턴스를 반영한 ‘생성’이라는 점에서 착안한 생성모형 기억 시스템 등등. 모두 인간에게 나타나는 기억의 특정 측면을 반영하면서 공학적으로도 그 논문 발표 시점에서의 최신 딥러닝 모델들을 근사하게 적용하여 제안했었죠.

정신적인 시간 여행(Mentally time-travel)

이터널 선샤인에서 남자(짐 캐리)는 기억을 지워준다는 의사를 찾아갑니다. 괴상한 장치를 머리에 쓰고 그녀에 대해 여러가지를 떠올리라는 과제를 받게 되죠. 그리고 그렇게 기억을 떠올리는 순간 활성화된 뇌의 영역들에 전자기적 충격을 주면 특정 기억을 제거할 수 있다는 의사(설정입니다 설정)의 설명이 이어지고, 곧 기억제거 시술이 시작됩니다.

어느새 잠이 든 남자는 꿈을 꾸듯 자신의 기억의 한 장면을 바라보고 있습니다. 이별 직전까지 치달은 그와 그녀의 말싸움의 한 순간. 우울하게 그걸 바라보고 있는데 점점 그 장면이 어두워지고 다시 새로운 과거의 어떤 시점으로 떨어집니다. 삭제가 된 것이죠!

마치 시간여행자가 된 것 같지 않습니까? – 다만 오로지 과거로만 갈 수 있습니다 – 이렇게 자신의 기억 속을 여행하는 짐 캐리. 굉장히 재밌게 묘사된 영화적 장치였습니다만, 놀랍게도 인지과학자들도 기억의 특정 측면을 실제로 시간여행의 메타포로 설명합니다.

기억은 여러 측면으로 묘사될 수 있는데 그 중 저장되는 방식의 관점에서 ‘일화적 기억(episodic memory)’과 ‘의미적 기억(semantic memory)’로 구분할 수 있습니다. 그 중 일화적 기억은 자신의 개인적 사건들을 중심으로 구성된 기억입니다. ‘자전거를 처음 탔던 순간’, ‘처음 해외 여행을 갔던 날’을 기억하는 것이 ‘이순신이 태어난 날’을 기억하고, ‘광복절의 역사적 의미에 대한 지식’을 기억하는 것과 구분된다는 것이죠. 이 일화적 기억이 마치 과거의 특정 시점으로 시간여행을 하는 것과 같다는 의미에서 심리학자들은 정신적 시간여행(Mentally time-travel)이라고 불렀습니다. 영화에서 남자는 계속 그녀와 연애를 하는 장면(기억)들을 목격합니다. 이때 ‘그녀와 식당 갔음’이라는 어떤 지식이 떠오르는게 아니라 그녀와 함께 있던 그 순간의 소리, 음악, 맛, 냄새, 말, 얼굴, 감정 등이 함께 떠오르는 것이죠.

HTM

자 드디어 논문 소개입니다. 그 전에 여담. 지금부터 소개할 논문에서 딥마인드는 자신들의 기억시스템을 줄여서 HTM이라고 부르고 있습니다. 생물학적 영감을 얻은 인공지능쪽에 관심많은 분들이라면 뭔가 떠오르지 않습니까? 네, 누멘타라는 연구 그룹이 오래전부터 밀고 있던 모형도 HTM이죠. 다만 누멘타의 HTM은 HTM(Hierarchical Temporal Memory)이고 이번 딥마인드 논문의 HTM은 HTM(Hierarchical Transformer Memory) 입니다. 그래도 이쪽 선배격인 누멘타가 예전부터 찜했던 약어를 모를리 없었을텐데요. 인터넷에 누군가가 ‘왜 딥마인드는 누멘타를 무시합니까?’라고 물어보는 글을 올린 것을 (https://discourse.numenta.org/t/why-is-htm-ignored-by-google-deepmind/2589) 본 적이 있었는데, 이런 점들을 보면 정말 좀 거리를 두는 것 같기도 하고(약간 농담인 것 아시죠?).

여담이 길어졌는데, 딥마인드가 가진 기존 인지과학적 영감 기반 인공지능 연구 그룹과 어떤 차이가 있다는 것을 보여드리고 싶어서 좀 써봤습니다. 여러 차이가 있지만 기본적으로 딥마인드의 전략적 영리함이 반영되는 것일 수 있습니다. 그들은 생물학적(정확하게는 신경과학) 영감을 기반으로 한 인공지능 시스템을 만들려고 합니다. 다만 생물학적 디테일을 지키려고 하는 것은 아니에요. 선배격인 누멘타의 HTM은 여러 실제 신경과학에서 밝혀진 현상과 제약사항들을 충실히 반영하려고 애를 씁니다. 그러나 딥마인드는 그 보다는 시스템이라는 측면을 더 중요하게 생각합니다. 기억 시스템의 구조적 측면을 좀 더 받아들이고, 그 세부적인 부분은 현 시점에서의 머신러닝 모듈들을 적절히 레고 블록처럼 쌓아서 만들려고 하죠. 그래서 이번에 소개한 HTM도 요즘 핫한 트랜스포머를 기반으로 개선했습니다.

Towards mental time travel: a hierarchical memory for reinforcement learning agents

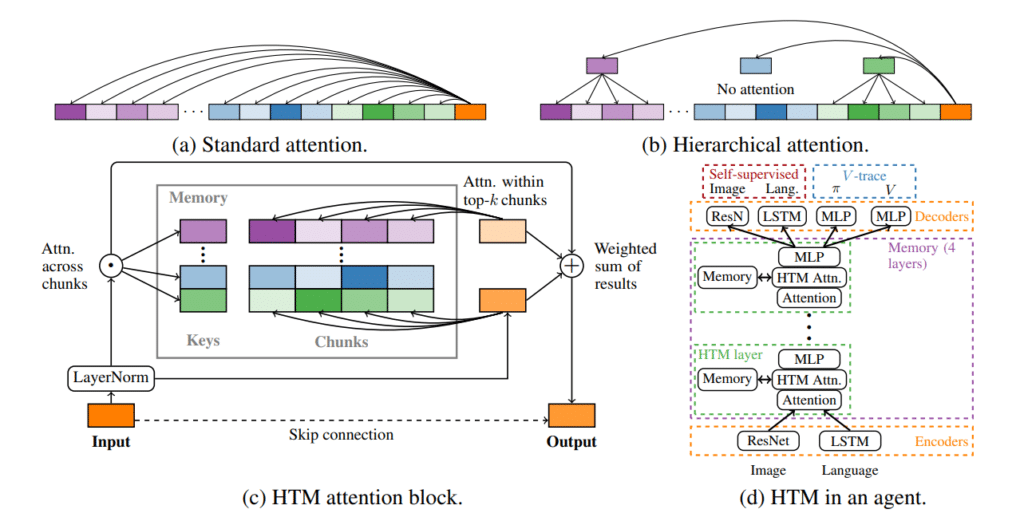

이 논문의 키워드는 다음과 같습니다. 강화학습 에이전트, 일화적 기억, 계층형 어텐션 트랜스포머, 기억 스판(청크). 문제의식은 다음과 같습니다. 강화학습 에이전트에 기억 시스템을 결합하려는 연구도 꽤 있었습니다. 그런데 대부분 새 과제를 받거나 혼동되는 요소들이 섞이면 학습에 실패하는 경향이 있었죠. 과거의 학습 경험이 새 학습 이벤트나 유사한 과제에 의해서 간섭받는 현상은 특히 딥러닝 기반 모형의 잘 알려진 약점입니다. 그리고 트랜스포머로 강화학습 에이전트의 기억 모듈로 사용하려는 연구도 꽤 있었습니다. 그 전까지는 LSTM을 써서 구현했는데 그 보다 더 좋다는 트랜스포머를 쓰면 성능이 더 올라갈 줄 알았습니다. 근데 생각보다 다른 영역에서 꽤 효율적이던 트랜스포머가 강화학습 상황에서는 별로였다는 결과가 계속 보고되었죠. 이를 극복하려고 트랜스포머의 구조를 개선합니다. 근데 크게 개선되지는 않았어요. 또한 셀프 어텐션의 유연함을 통해 좀 더 긴 과거(긴 이벤트 시퀀스)도 효율적으로 기억하고 다룰 수 있을 것이라고 생각했는데 생각보다 잘 안되었습니다.

이 논문에서는 그 이유로 두 가지를 제안합니다. 하나는 ‘기억해야 할 과거’를 좀 더 덩어리(청크)로 쪼개어야 한다는 것이죠. 기억은 단순히 일어난 일들의 연속이 아닙니다. 여러 불연속적인 에피소드들이 뒤섞여 있습니다. 영화 이터널 선샤인에서 짐 캐리가 자신의 과거 여러 장면들을 점프하듯, 그렇게 어떤 청크의 형태로 과거가 저장되어야 있고 필요한 청크들 사이를 점프하듯 해야 한다는 것이 이 논문에서의 주장입니다.

다른 하나는, 이 쪼개진 과거들 중 연관있는 청크들이 선택되면 그제서야 그 세부사항들에 주의를 기울이면 된다는 주장입니다. 즉 우리는 썸네일들을 보면서 빠르게 영상을 훑어보다가 관심이 가면 그때서야 그 지점에서 멈추고 천천히 틀어보지 않습니까? 일화적 기억도 그런 식으로 접근해야 한다는 것이죠.

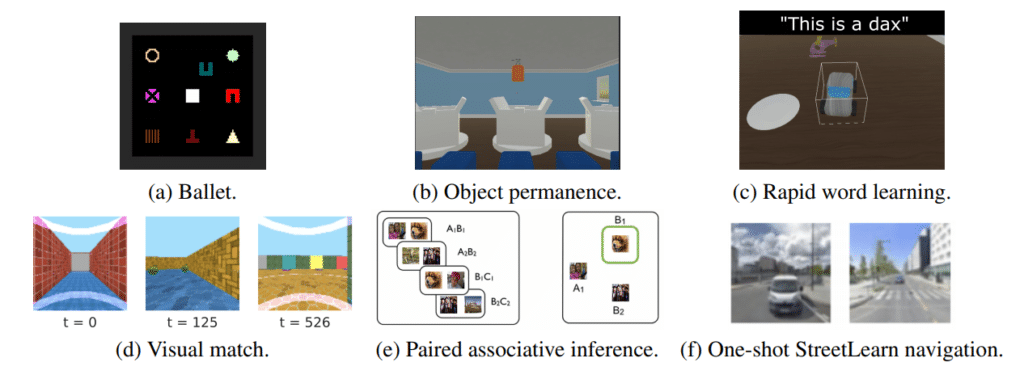

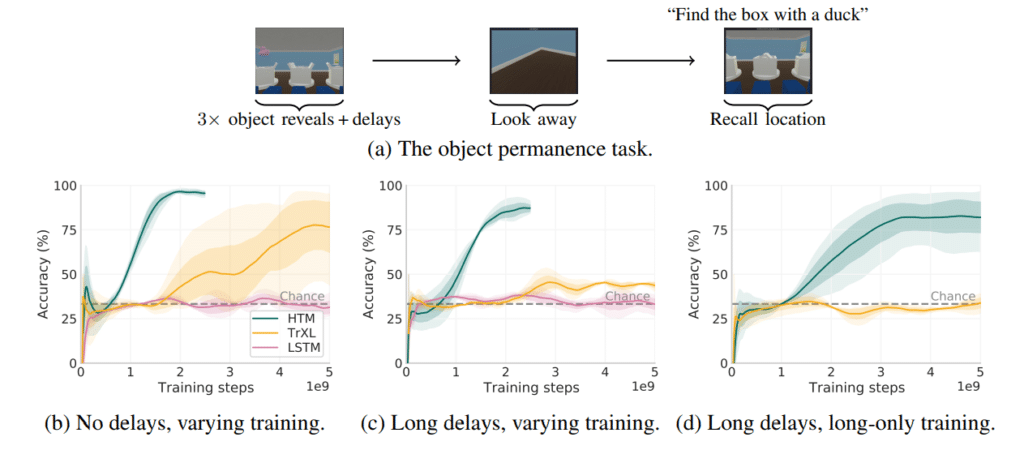

그래서 청크로 쪼갠 ‘과거의 요약본’을 기반으로 작동하는 어텐션(상위 어텐션)과 그 덩어리의 세부 요소들을 살펴보는 어텐션(하위 어텐션) 으로 계층적으로 구성하자. 는 것이 HTM의 핵심입니다. 그리고 그 성능을 실험하기 위해 유니티 기반 가상 환경에서 시각적/언어적(텍스트) 자극을 주고 여러 기억 과제를 시켜요. 결과는 기존 모델들보다 더 좋거나 더 효율적입니다.

비행기는 새의 날개짓을 그대로 모방하지 않았다

재밌는 논문이지만 이 결과가 에이전트의 ‘기억 시스템’을 진보시켰느냐? 라고 한다면 확신을 가지고 대답하긴 어렵습니다. 그동안 딥마인드가 꾸준히 기억 모델을 제안했지만 생각보다 현실에서 파급력이 크지는 않았어요. 근본적으로는 인공지능에게 ‘기억’을 부여하는 것이 풀기 어려운 문제라는 점이 그 이유겠지요. 하지만 다음의 이유도 있을 것 같습니다. 딥마인드가 기존의 선배 연구자들보다는 ‘생물학적 영감’을 곧이곧대로 옮기는 실수를 피하려고 애를 썼지만, 여전히 그들은 좀 더 최근의 실용적 연구집단 보다는 자신들의 선배쪽에 가깝습니다. 어느 논문에서 딥마인드가 인정했다시피, 자신들의 기억 모델이 더 성능이 좋지만 큰 규모의 시스템으로 확장하거나 동료 연구자들이 추가 개선을 하는 연구를 하기엔 너무 복잡하다고 말하죠. 그래서 이번 논문도 어느 정도는 단순함을 추구해서 트랜스포머를 실용적으로 활용하는 방식으로 선회한 편입니다. 그렇지만 여전히 OpenAI의 GPT-3 처럼 간단한 구조를 쌓아서 규모를 키우고 데이터를 무미무시한 규모로 쏟아부어 만드는 전략보다 더 인상적인 결과물을 보여주곤 있지 않는 것 같아요. 인공지능이 모방하고 획득하고 싶은 인간의 특정 정신적 기능이 구조적 측면을 가지고 있다는 것은 타당한 주장입니다. 하지만 그것을 특정 구조를 통해 해결하는 것이 타당한지는 아직 증명되지 않은 것 같습니다(개인적으론 이쪽을 더 지지합니다만). 일단 두 방향 모두를 인정하고 지켜보는 수 밖에 없겠죠.

흠없는 마음에 비추는 영원의 빛

인공지능의 학술적 측면에서, ‘기억’ – 특히 오늘 소개한 방식으로 해법을 마련하게 된다면 어떤 유익이 있을까요? 더 복잡하고 긴 문제를 인공지능이 잘 풀 수 있습니다. 메타러닝이나 퓨샷 러닝 태스크 등도 더 잘 해결할 수 있습니다. 복합적인 문제를 연속적으로 학습하며 개선해나가는 모형을 구축할 수 있습니다.

하지만 또한 ‘기억’은 인간의 중요한 요소입니다. ‘나’와 ‘관계’를 정의하는 핵심 요소이죠. 영화 이터널 선샤인에서, 주인공은 기억이 삭제되는 중간에 그걸 멈추고 싶어합니다. 최근의 기억부터 삭제되는 방식인지라, 처음에는 이별 직전의 안좋았던 일들, 감정들을 위주로 삭제가 일어납니다. 하지만 점점 삭제가 더 과거로 진행되면서, 그가 만나는 장면들은 기쁨과 설렘, 의미와 공감으로 충실한 기억들입니다. 이제 그건 단순하게 상대에 대한 것만이 아니고 자기 자신의 중요한 일부인 것이죠.

그래서 영화의 원제가 ‘흠없는 마음에 비추는 영원의 빛 Eternal sunshine of the spotless mind’ 인 것 같습니다. ‘기억’은 영원히 우리를 비출 것이며, 그 장면들에는 분명 흠없는 마음이 있을 것이니까요.

그러므로 ‘기억’을 인공지능에게 제대로 부여할수록 우리는 좀 더 ‘인간적인’ 인공지능을 목격할 가능성이 높아질 것이라고 생각합니다. 그 인공지능은 우리의 함께 성장할 것이고, ‘흠없는 마음’을 가지기 시작하는 그 순간을 ‘기억’이 비추는 것이 가능하기 때문에 말이죠.

처녀의 제비뽑기와

잊혀진 세상에 의해 잊혀져가는 세상과

흠없는 마음에 비추는 영원의 빛과

이루어진 기도와

체념의 소망은 얼마나 행복한가

How happy is the blameless vestal’s lot?

The world forgetting, by the world forgot.

Eternal sunshine of the spotless mind.

Each prayer accepted and each wish resigned.

References

- Towards mental time travel: a hierarchical memory for reinforcement learning agents – https://arxiv.org/abs/2105.14039