[服务开发团队,Yeji Jo]

当我们通常定义类人 AI 时,我们是说它是一个像人一样行动和像人一样思考的 AI。虽然每个人所期待的人工智能的形态和形式各不相同,但迄今为止,人们正在做出各种尝试来实现许多人所追求的人工智能。

人工智能拟人

那么当人工智能看起来最人性化时,它最终会是什么样子?

至此,距离2016年初李世石和AlphaGo的围棋比赛已经过去了6年,当人们对AI的兴趣开始增长时,我们可以看到,即使通过与AI的各种交互体验,塑造AI的形象对我们来说也大不相同. 有。

在李世石和AlphaGo的围棋比赛中,AI赢得了李世石期望获胜的比赛,他隐约将未来出现的AI视为恐惧的对象。然而,奇怪的是,根据波士顿学院研究员 Chang-Hoon Oh 的说法,通过他与人工智能的第一次互动,他能够看到人工智能被描述为有创造力或无情的人类的例子。

此外,根据Oh研究员的实验,在AI和人类齐心协力的情况下,人类在执行任务时可以选择领导或协助。在这个实验中,我们可以看到人们希望在引导和辅助功能上都带头。换句话说,我们可以看到,当人类做出最终决定时,我们期望人工智能只扮演辅助角色。此外,在合作的过程中,他能够在与他人交谈、教学和表达情感的方式中看到人工智能的化身。

当AI执行优于人类的任务时,普通人会感到与AI的距离感或将其描绘成可怕的生物,可见在与AI交谈的过程中,您希望进行更详细的交流,而不是简单的对话。

或许在增加与 AI 交互的过程中,没有提前赋予 AI 特定的形状或框架,人们可能会通过自己的经历赋予 AI 不同的个性。

同情的基本要素:智力和情感

那我忍不住问下一个问题。为了与人类“交流”,人工智能最需要哪些元素?

如果我们考虑形成类人 AI 的主要元素,我们可以说智能和情感是我们与 AI 交流时最关注的部分。可以说,和人类一样聪明,能够拥有人类情感的人工智能,就像人类一样。这与迄今为止出现的智能计算机比人类更快、更准确地执行任务的形象截然不同,是我们未来必须解决的挑战。

而且我认为表达类人智能和类人情感最具代表性的方式是通过对话。

作为形成这种对话的基本形式,您可以找到行业的许多方面试图用各种声音和语言来解决它。这将是让人们认为在与人工智能交谈时,如果他们拥有与人类相同的声音和情感的声音,他们会更像人类的一方面。

此外,正在尝试使用作为对话核心的语言来与人交流。理解人类语言,不是仅仅看语言的意义、语法结构和语境,而是试图把握和表达句子所包含的情感。一个例子是 GPT-3,这是一种自然语言处理技术引擎,它通过只插入几个关键词来像人类一样表达,从而创建 500 个字符的中文句子。

而一旦达到一定程度使用类人台词的阶段,为了将其解开为更多样化的对话,下一步就是用记忆和对话材料解开它。以 Facebook 的 Blender Bot 2 为例。尝试了5轮以上的长时记忆,深入理解前后的语境,并反映在谈话中,通过实时网络搜索可以看出它反映了各种谈话材料。

如果是通过对话捕捉智慧和情感的一个方面,您可以以不同的方式尝试什么?

当前活跃的研究之一是识别人的情绪并与之互动,以便从各个角度了解人的情绪。一个典型的例子是软银的 Pepper,它分析面部和情绪,而 Neurodata 实验室也在不断尝试通过分析人类的行为和情绪,特别是语音、面部表情、心跳和呼吸来识别人类的情绪。

另一方面,捕捉人类智能的下一个尝试是 AGI。在我们学习的过程中,我们经常看到我们在一个学科中学到的知识与其他学科或我们生活的其他领域相关联或被应用。同样,在人工智能行业,我们现在正在寻求将一种知识用于通用目的,而不是将其用于一个目的。

通用性是指它可以在各种上下文和环境中使用,在遇到意想不到的新问题时可以解决问题,并且可以利用在解决一个问题的过程中学到的经验和知识来创造另一个问题。解决问题。

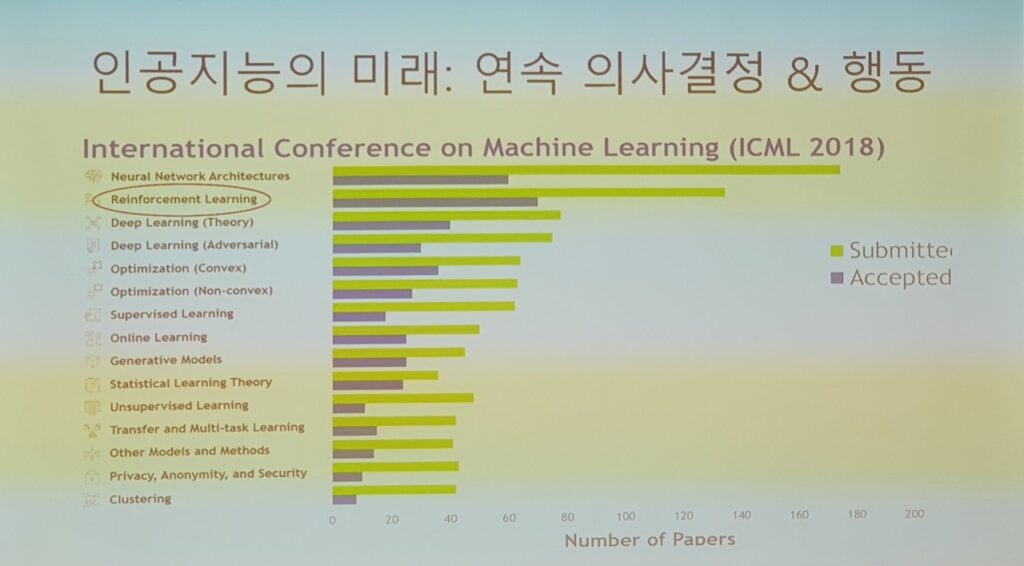

为了解决这种通用人工智能,通常使用强化学习。事实上,许多专家都在关注,如果大规模 AI 语言模型是当今的趋势,那么用于决策的强化学习将是下一个趋势。之所以有这种可能,是因为现有的强化学习模型是为了执行一项任务而训练和设计的,因此无法在其他游戏中使用,或者性能显着降低,导致缺乏灵活性。现有的强化学习场景是在给定环境中为实现一个目标而奖励交互的场景,DeepMind 的 XLand 最近开发了一个集成平台,而不是单独的训练环境。

人工智能伦理

如果像这样创建一个同时捕捉情感和智能的人工智能,我认为我们需要解决的最后一个任务是伦理。

AI模型是用大量数据训练出来的,而数据本身就已经存在偏差,所以AI学习到的数据也反映了固有偏差的现实。已经在微软发表偏颇言论的 TAY、亚马逊对女性求职者不利的招聘系统以及韩国的 Iruda 事件都证明了人工智能伦理的实现是使用该服务的先决条件。

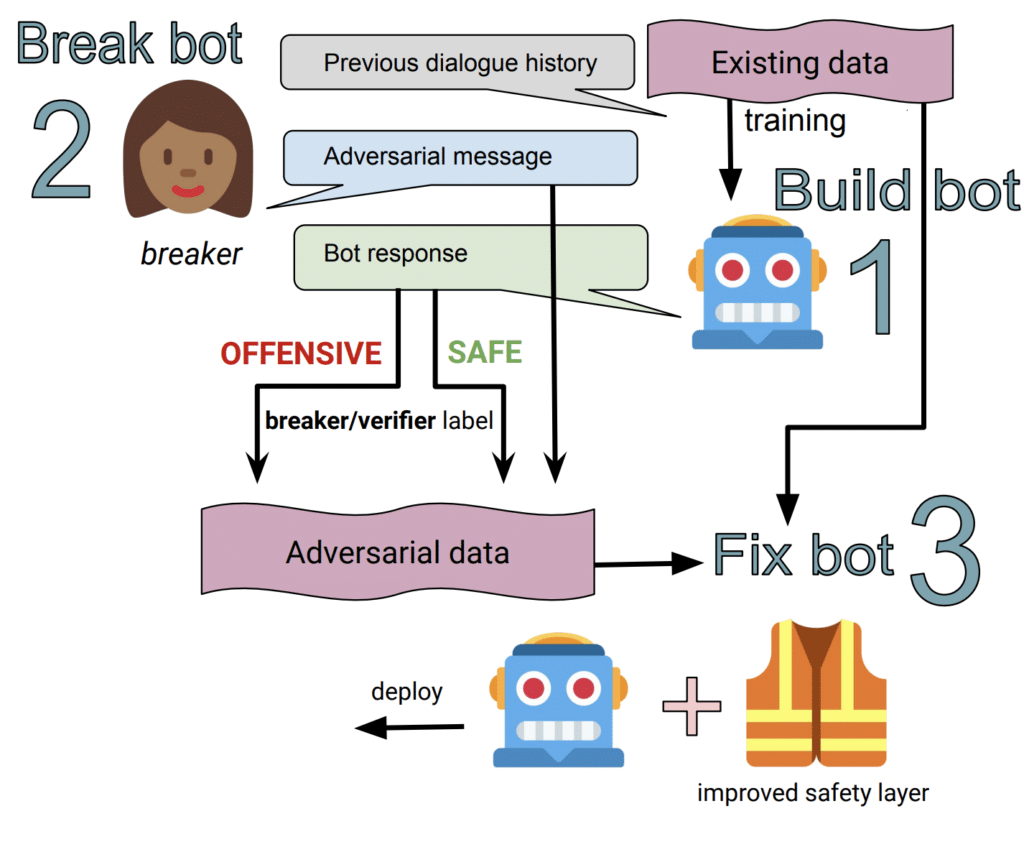

正在做出各种尝试来解开这种道德观点。随着技术变得越来越先进,内部结构变得越来越难以理解。它不是进行后干预,而是进行前干预,从学习阶段过滤和学习有偏见的数据,而 Facebook 的 Blender Bot 2 提供了前干预和后干预-通过攻击性和正常语音分类器进行干预。正在做出各种尝试来解决这个问题。

创建类人 AI 可能需要无休止的优先排序和重新定向,或许,以创建每个人都能理解的级别和价值。为了设想一个具有人类水平的智能和感性以及一个可以被许多人接受的共同伦理观点的人工智能,我们期待着在创造类人人工智能之前创建以人为中心的人工智能的那一天。