[서비스개발팀 임용택]

2015년 6월, 미국 브루클린의 한 흑인 프로그래머는 여자친구와 찍은 사진을 보려던 중 깜짝 놀랄 일을 경험합니다. 구글 포토에 본인들의 사진이 “고릴라” 로 오토 태깅된 것을 보았기 때문입니다. 구글은 빠르게 대응했습니다. 두 시간도 되지 않는 시간에 구글은 오토 태깅을 잠시 중단시키고, 사용자의 계정에 접속해 원인을 분석함과 동시에 진심어린 사과를 전해 상황을 정리했습니다.

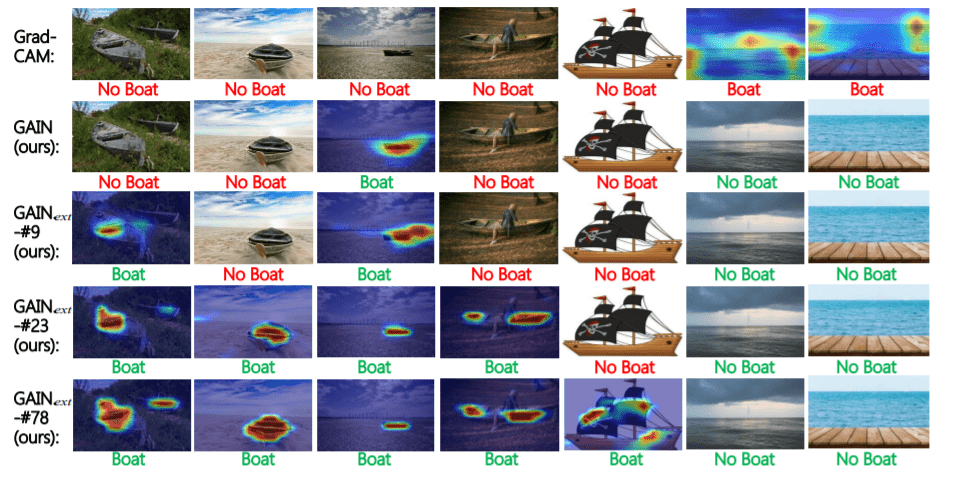

왜 이런 일이 일어났을까요? 이 일을 이해하기 위해선 bias라는 개념을 알아야 합니다. 쉽게 말하면 데이터 셋에 의해 머신 러닝 모델이 가지는 일종의 편견 을 의미합니다. 머신 러닝에 대한 성숙도가 부족했던 시기였기에 적절한 데이터가 준비되지 않았고, 구글의 오토 태깅 서비스는 흑인을 고릴라로 분류하게 된 것이죠. 검정색 피부를 가진 사진이 대부분 고릴라였거나, 사람, 친구, 연인 등의 클래스에 흑인의 데이터가 없었기 때문일 것입니다. 조금 더 예시를 들어보겠습니다. 2018년 CVPR에 등재된 “Tell Me Where to Look:Guided Attention Inference Network”(이하 GAIN)이라는 논문에서는 올바른 Attention Map을 만들기 위해 어떻게 하면 CNN 모델이 이미지 데이터의 모든 부분을 참고해 의사 결정을 할 수 있을까에 대해 고민합니다. 여기서 제시한 흥미로운 예시는 boat-water bias 입니다. boat 이미지를 boat 클래스로 분류하기 위해 모델이 어떤 부분을 주목하는 지를 나타내는 Attention Map을 확인해보니 정작 물이 있는지, 없는 지에 대해서만 확인을 하고 있었다고 합니다. 위 사진의 Attention Maps에서 빨간 색에 가까울수록 모델이 결정을 내리는 데에 많은 정보를 얻었다는 의미인데요, 기존의 방법론인 Grad-CAM 에선 모델이 분류를 하는 데에 배를 보고 배라고 분류하지 않았다는 것을 보여줍니다. 모든 배 사진이 물을 배경으로 했기 때문에, 모델은 “boat” 라는 클래스의 데이터들을 묶을 공통적인 특징으로 물의 유무를 사용한 것입니다.

아마존에선 AI 채용 시스템을 사용하던 중 여성 지원자를 차별하는 이슈가 발생해 도입을 취소했다고 합니다. 실제 채용된 직원의 이력서와, 지원자의 이력서를 인공지능 모델을 이용해 비교하여 유사한 결과를 보이는 직원을 채용하였습니다. IT기업의 성별 불균형 때문일까요, “여성”이 들어가는 단어를 사용하면 감점하거나, 남성이 자주 사용하는 어휘가 사용된 이력서에 높은 점수를 주는 일이 있었다고 합니다.

머신 러닝을 이용해 서비스를 제공한다면 위의 예시들과 같은 판단을 막아야 합니다. 사실 가장 좋은 해결책은 모델을 학습할 때 균형 잡힌 데이터 셋을 사용하는 것입니다. 충분히 확보된 흑인과 고릴라의 사진, 물이 없는 곳에서도 찍힌 보트의 사진, 비슷한 비율의 여성, 남성 지원자, 합격자의 이력서처럼 말이죠. 하지만 현실의 데이터는 bias를 품는 경우가 대부분입니다. 데이터를 준비하는 인간부터 bias를 가지고 있어 이것이 데이터에 반영되는 경우가 많기 때문입니다. 현실의 데이터 셋에서 머신 러닝 모델이 판단을 내리는 데에 bias를 최소화 시키는 것을 목표로 연구하는 키워드를 AI Fairness 라고 합니다. 인공지능이 널리 사용되는 지금, 올바른 판단을 내리는 것은 중요한 이슈입니다. 이러한 흐름 속에서 IBM 에서는 Fairness를 위한 툴 AI Fairness 360 을 공개하였습니다. 데이터의 bias를 확인하거나, fairness를 위한 metric을 제공하는 등 다양한 API를 제공합니다. 이러한 키워드도 있다는 것을 감안하여 합리적이고 설명 가능한 머신 러닝 서비스를 제공하는 데에 도움이 되길 바랍니다.

Reference

https://www.chosun.com/site/data/html_dir/2015/07/03/2015070300217.html https://arxiv.org/abs/1802.10171 https://aif360.mybluemix.net/# https://www.chosun.com/site/data/html_dir/2018/10/11/2018101101250.html