[행동지능연구팀 이정우]

바둑과 같이 경우의 수가 매우 많은 복잡한 게임에서 알파고는 최고 수준의 프로기사를 넘어서는 모습을 보여줬습니다. 알파고 이후에 진행 된 프로젝트인 알파스타, OpenAI Five에서는 실시간 전략게임에서 자원을 수집하고, 활용하고, 많은 수의 Unit을 컨트롤하고, 팀과 협업하며 게임 플레이가 가능함을 보여줬습니다. 그렇다면, 이런 인공지능들이 과연 사람 같은 인공지능이라고 이야기 할 수 있을까요?

앞에서 언급된 게임 인공지능들은 사람과 다르게 정보를 입력 받고, 해석하게 됩니다. 주로 공간 정보가 표현된 특징 값을 따로 표현하거나, x, y 좌표값, 가속도 등 수치화된 값을 입력으로 사용합니다. 사람처럼 시각적인 정보를 사용한다는 점에서 RGB 이미지를 이용해 연구 개발을 진행하기도 합니다. 이처럼 인공지능이 사용하는 정보는 사람과 매우 다르다는 것을 알 수 있습니다.

또한, 게임에 대한 정보를 게임 AI에게 너무 상세하거나, 사람은 얻기 어려운 정보를 반영하게 된다면, 공정성에 대한 시비가 발생 할 수 있습니다.특히, 컴퓨터라는 기계의 입장에서 사람과 동등한 조건을 만들어 내는 것은 어려운 일임을 알 수 있습니다.

“실제 사람의 입장에서 Human 게임 플레이어들은 어떤 정보들을 사용해 게임을 플레이 할까요?“

FPS 게임인 크로스파이어와 MMORPG 게임인 로스트아크의 e-sports 선수들을 보시면, 공통적으로 헤드셋을 착용하고 모니터를 통해 게임에 대한 정보를 인지하는 것을 볼 수 있습니다. 프로 레벨로 올라갈수록 순간적인 컨트롤뿐만 아니라, 팀 차원에서의 정보공유, 전략적 판단이 승부에 있어서 매우 중요해집니다. Human 게임 플레이어들은 음성 채팅을 통해 의사소통하며, 정보 공유와 함께 모니터 시야에서 보이지 않는 정보들을 귀를 통해 판단하게 됩니다.

특히 소리에 대한 정보는 특정 스킬을 사용할때 발생하는 사전 정보로 이후의 미래를 대비할 수 있고, FPS 게임의 경우 발소리, 총탄의 소리를 통해 보이지는 않지만, 대략적인 적의 위치와 전략을 유추해 볼 수 있는 중요한 정보로 사용 됩니다.

“Human 게임 플레이어들은 시각정보와 청각정보에 의존해 게임을 플레이 하는 것을 알 수 있습니다.”

그렇다면, 인공지능에게 사람과 같이 시각정보와 청각정보를 인지하도록 하고, 게임을 플레이하게 하면 Human-like 게임 AI를 만들 수 있지 않을까요?

이런 물음에 답하기 위해, Agents that Listen: High-Throughput Reinforcement Learning with Multiple Sensory System 연구를 소개 드립니다.

논문의 제목에서 알 수 있는 것처럼, 게임 AI Agent가 Listen! 들을 수 있다는 점을 강조 했습니다.

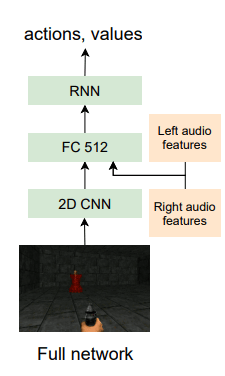

연구진들은 Human 플레이어처럼 시각, 청각 정보를 반영하기 위해, RGB 이미지 (시각 정보), 사람이 2개의 귀를 통해 소리를 느끼는 것과 같이, 오른쪽 소리 정보, 왼쪽 소리 정보 (청각 정보)를 분리해 실제 Human 플레이어가 모니터와 스피커를 통해 게임 정보를 사용하는 형태와 유사한 네트워크 구조를 설계 했습니다.

VizDoom 이라는 고전 FPS 게임에서 실험 환경을 구성했습니다. 첫번째 실험 환경은 4개의 장소에서 소리가 나오는 장소에 도착하면 성공하는 실험을 진행했습니다. 영상에서 시선의 방향이 앞에 있지 않더라도, 뒷 걸음을 통해 소리가 나는 곳으로 이동하는 것을 볼 수 있습니다. 실제 FPS 게임에서는 단순히 시각정보만으로 적의 위치를 판단하지 않고, 뒷 방향에서 발생하는 발자국 소리, 총, 수류탄 소리를 게임 플레이어가 해석해 시각적으로 보이지 않지만, 반응하는 경우들이 빈번하게 발생합니다. 첫번째 실험을 통해 게임 AI도 청각 정보를 활용할 경우 사람처럼 정보를 해석하고 플레이 할 수 있는 가능성을 보여줬습니다.

두번째 실험은 음성 명령문 예) 오렌지 나무가 있는 곳으로 가라!, 해골 기동이 있는 곳으로 가! 등을 게임 AI가 해석하고 명령문과 맞는 장소에 향하는 실험을 진행했습니다. 실험 결과에서는 간단한 환경이지만, 게임 AI가 음성 명령문을 해석하고 과제를 올바르게 수행하는 것을 볼 수 있습니다.

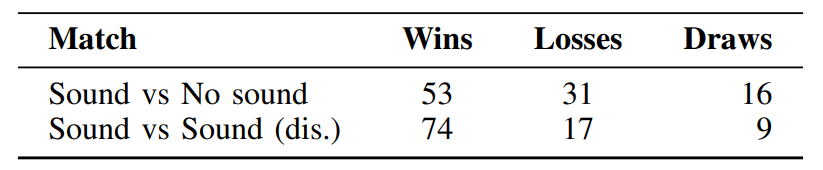

연구진의 실험 결과에 따르면, ‘시각 청각 정보를 함께 사용한 게임 AI’가 단순히 ‘시각 정보만 사용한 게임 AI’ 보다 더 높은 승률을 보이는 것을 알 수 있습니다.

오늘 소개드린 연구는 간단한 게임에서 시작하지만, 앞으로 지속적인 발전을 통해, Human 게임플레이어와 같이 음성채팅으로 전략을 논의하고, 함께 게임을 플레이할 수 있는 친구로 다가올거라 믿어 의심치 않습니다.

최근 인공지능 연구 개발의 트랜드는 다양한 modality(형태, Text, Speech, Vision 등) 정보들을 통합해 활용하는 방향으로 발전하고 있습니다. 사람도 특정한 일을 하거나, 활동을 할때 1가지의 감각 정보가 아닌, 다양한 감각 정보들을 취합하고 두뇌에서 분석해 행동하게 됩니다. 앞으로 다양한 modality들이 통합되면서, 인공지능의 새로운 가능성을 보여줄 것으로 기대 됩니다.

스마일게이트 AI 행동지능연구팀은 발전하는 게임 AI 기술의 다양한 가능성을 탐구하고, 유저들에게 즐거움을 주기 위해 연구 개발을 진행하고 있습니다.

감사합니다.

Reference

[1] https://sites.google.com/view/sound-rl

[2] https://github.com/deepmind/pysc2